AI 的「盲人摸象」時代結束了 -深度解析

👋 哈囉,我是 MarkIncome!歡迎收看這期 ✨ 訂閱版 ✨ MarkIncome Newsletter。每週我都會聊聊新創、轉職和創業的大小難關,用真實經驗幫你少踩坑。

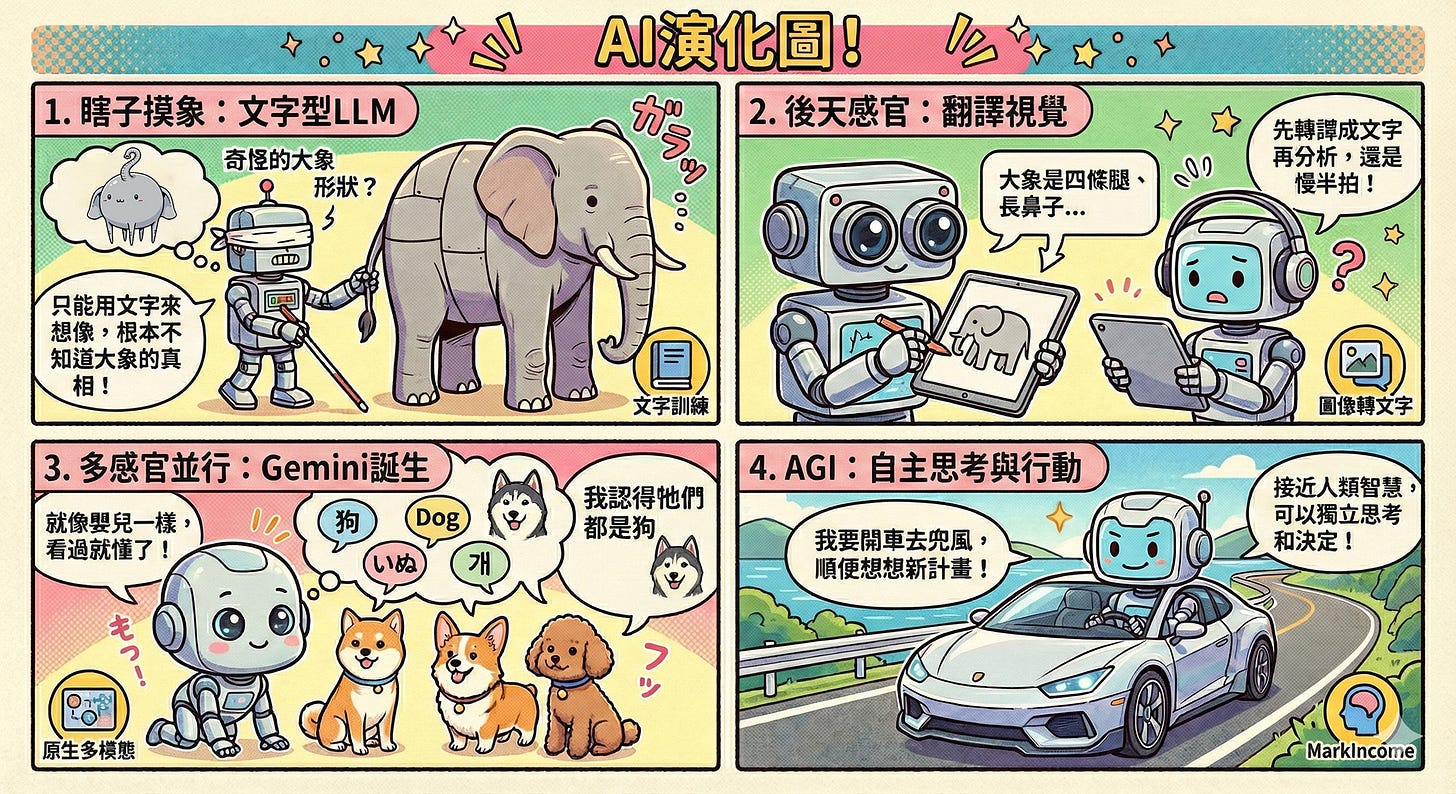

想像一下,如果一個人工智慧從來沒見過大象,只聽過關於大象的文字描述,它會認為大象長什麼樣子?這就是過去 AI 面臨的困境。但現在,一場革命正在悄悄發生,徹底改變 AI 認知世界的方式。

Phase I:從文字起家的LLM與「盲人摸象」的先天限制

▋ 從文字中誕生的 Transformer:知識的「二度轉譯」

那些大型語言模型(LLM),骨子裡就是一個純粹用文字訓練出來的 Transformer 模型。你可以想像,它從小到大,就是一個被關在圖書館裡面的書呆子,只會讀書,只懂文字。它的整個世界觀、它的知識體系,都是透過文本文字建構起來的。它對真實世界,是徹底陌生的,這是一個先天上的限制。

後天加裝的感官:治標不治本

後來大家發現,光會讀書不行啊,AI得會看圖、會聽聲音。所以,它們才在這個純文字的基礎上,硬是加上了多媒體和多模態的能力。

你可以上傳一張圖片、一段影像、甚至是(背景談話聲),叫它分析裡面的東西。

但你猜怎麼著?它還是得偷吃步。它本質上是將這個圖片轉化回文字,再用它熟悉的文字邏輯去分析。

這種處理流程,在技術上叫做「後期融合」(Late Fusion),它不是真正地在「看」,而是在進行「翻譯」。這就像你給一個外國人看一張照片,他得先在腦袋裡把照片的內容翻譯成他的母語,然後再用他的母語思考。中間的資訊和「風味」早就丟失了。

▋ 一個天生盲人的世界

所以,它天生就有如一個盲人,從來就沒有看過真實的世界,只是靠「聽」這個東西的描述。它知道大象有「四隻腳、長長的鼻子、灰色的皮」,這些都是文字告訴它的。就算它試著去「摸」,也只是像那些盲人一樣,摸到大象的腿、或是耳朵的一個部分。它只能聽到大象長的樣子,而它想像中大象的形狀可能和真正的大象相去甚遠,就是從來沒有看過真正的一個大象的全貌。它的認知是碎片化、間接化的。

▋ 視覺與文字的「聯合不起來」

後來它們試著把視覺模組加進來,但因為兩個系統是獨立訓練的,硬是要合在一起,它們之間的溝通總是會卡住,會出現「聯合不起來」的狀況。這就像你把兩塊不同語言的積木硬是黏在一起,它們的邏輯和語義空間根本就不匹配。這種舊式的多模態,最終推理的權力還是牢牢掌握在那個文字上的 transformer 手中,視覺只是個提供文字描述的輔助工具。這是一個無法迴避的結構性困境。

Phase II:Gemini 的認知啟蒙——模擬人類嬰兒的學習模式

▋ Gemini Pro 的革新:從「一開始」就是完整的人

不過,現在最新的 Gemini Pro 出現之後,整個遊戲規則就改寫了。它厲害的地方,就在於它從一開始的設計理念,就不是要訓練一個「文字腦」再外掛視覺。它從頭開始,就是一個完整的人,它有視覺、聽覺的輸入,你甚至可以想像,未來可能連觸覺的輸入都會有。這種設計哲學,完全是向人類嬰兒學習的。

直接「指認」世界的奧秘

一個幼兒怎麼樣接觸世界,就算他還沒有語言的能力,你指著自己說「這是爸爸」,指著書本說「這是書本」,指著一隻小狗說「這是一隻小狗」。重點是,這個過程是多感官並行的。幼兒的大腦不是先聽了一堆文字描述,再去對應。

▋ 人類知識的建立:看過就是理解

我們人類從來都不是靠那種「說明書」式的文字描述來學習的。你不會告訴孩子:小狗的形狀是有四隻腳、它有長的毛、它的顏色是咖啡色的、毛的長短是中等長度...你不需要這些規格表。人類不是這樣學習的。我們是看過一些小狗、一些椅子之後,大腦中自然就會建立一個多維度的認知,就知道小狗、椅子,以及其他東西是怎麼樣的。這種認知,是直接的、感官整合的。

▋ AI 追逐的方向:統一的圖片與概念認知

其實現在的AI發展,就是朝著這個方向在走,它已經不只是在做單純的「圖片的認知」,它在做的是所有感官資訊的統一大認知。

它正在努力打破模態之間的藩籬,讓知識在視覺、聽覺和文字之間自由流動,而不是被文字給卡死。這是一種從底層架構就開始的認知重塑。

Phase III:Gemini 三點零的核心技術突破——統一詞元空間與聯合訓練

▋ Gemini 三點零:所有模態的「同步訓練」

Google Gemini 三點零 最厲害的地方是什麼?它徹底顛覆了舊的做法,它是把文字、圖像,以及其他多媒態的數據,是同一個時間一起拿給AI去訓練的。

這在技術上代表著巨大的工程難度,但帶來的效益也是革命性的。

在這之前,所有的訓練都是分開的。你可以想像成,所有模態都在各自的「科系」上課:文字跟文字、圖片和圖片、聲音跟聲音等等,都是分開來訓練的。它們各自生成自己的「嵌入向量」或「表徵」。

▋ 第二代只是獨立模組的「硬組合」

就算後來我們看到了所謂的第二代多模態模型,它也只不過是訓練好幾個獨立的模組,然後再用一個小小的、低效的投影層來進行「組合」或「後期融合」。它們的知識庫是分家的,只是被一個「翻譯官」強行聯繫起來。它不是一個從出生開始就是一個完整的多媒態的 AI。

▋ 原生多模態的秘密:

統一詞元空間(Shared Token Space)

Gemini 的架構則完全不同,它採用了所謂的「統一詞元空間」(Shared Token Space)和「端到端原生多模態訓練」。簡單來說,不管是文字、圖片的像素塊(patches)、還是聲音的頻譜,它們統統都被轉化成同一套通用詞元來處理。這讓所有的模態從一開始就在同一個大腦裡互相影響、互相學習,而不是在兩個分開的辦公室裡交換翻譯文件。

▋ 交叉模態注意力:實現真正的「看圖思考」

有了這個統一詞元空間,Gemini 的 Transformer 骨幹就能在自注意力機制中,實現真正的交叉模態注意力。這意味著,在模型思考的過程中,圖像的空間資訊和文字的語義邏輯可以並行、同時地影響彼此。

這就讓AI直接「看著」圖片來思考,而不是先「翻譯」成文字。

Phase IV:結論與深遠影響——通往AGI的關鍵基石

▋ DeepMind 創辦人的判斷:非常接近 AGI

這就是為什麼 DeepMind 這個創辦人,Demis Hassabis,才會如此肯定地說,Gemini 的進展有可能讓AI很接近 AGI(通用人工智慧)了。因為這種「原生統一」的認知架構,

已經解決了通用智能最基礎的一個問題:如何全面、不失真地感知和理解這個世界。

這種能力體現在具體應用上就是:當你叫 Gemini 的圖片來介紹身體的器官時(見附圖),它可以在正確的位置將名稱與圖片完美連接。它不是依賴一個文字描述的框線,而是像一個真的看懂了圖片的人一樣,進行精確的指認和定位。

這表明它的知識已經內化在一個統一的多模態表徵中了。

因為它現在擁有的是像人類一樣的認知架構,它不再是一個只能靠聽覺、靠二度轉譯文字來認識世界的盲人。它擁有了直觀的、感官整合的理解能力。這種能力讓它在處理複雜的、需要空間推理或時序理解的任務上,展現出質的飛躍。

Phase V:技術細節的魔鬼——「統一詞元空間」到底多厲害?

▋ 統一詞元空間:打破模態的語言障礙

前面我們提到了「統一詞元空間」(Shared Token Space),這絕對是 Gemini 三點零 架構中最「黑魔法」的一部分。你要知道,在舊的模型裡,文字的嵌入向量(Embeddings)和圖片的視覺嵌入向量,它們住在兩個完全不同的語義空間裡,它們使用的「語言」是不一樣的,就像一個說中文、一個說英文。而統一詞元空間,就是為所有模態建立了一個共同的通用語。

將世界萬物「像素化」成同一種語言

具體來說,文字被切分成 BPE(Byte Pair Encoding)詞元,圖片被分解成許多小塊的視覺補丁(Vision Patches),音頻被轉換成時頻圖後,也被切分成類似的補丁。重點是,所有這些不同類型的「詞元」或「補丁」,都被投影到同一組共享的向量空間裡。

這就像是把整個世界——從一段文字描述、到一張照片、到一個聲音,都轉化成同一個編碼系統的數據。

Transformer 骨幹:真正實現交叉模態學習

這樣一來,所有的資訊流,無論是文本、視覺、還是聲音,就可以被串聯成一條長長的序列,送入單一的 Transformer 骨幹網路進行處理。在 Transformer 的自注意力機制(Self-Attention Mechanism)中,這條序列中的每一個詞元,無論它來自文本還是圖像,都能夠直接「看見」並影響序列中的其他所有詞元。

▋ 終結「後期融合」的低效與損失

這徹底終結了舊模型那種「後期融合」的低效和資訊損失。以前,視覺資訊經過獨立的視覺編碼器被「壓縮」成一個低維度的描述,再硬塞給語言模型。現在,Gemini 是讓高解析度的視覺細節和高解析度的文字語義,在 Transformer 的每一層都進行深度互動和計算。這大大提升了它進行細粒度跨模態推理的能力。

「稀疏計算」的秘密:混合專家(MoE)

為了處理這種龐大、多維度的統一輸入,Gemini 還大量運用了混合專家層(Mixture of Experts, MoE)的架構,這也是它能在保持高效能的同時進行大規模擴展的關鍵。你可以想像,不同的「專家」網路被設定來專門處理特定類型的詞元(例如,有些專家可能更擅長處理視覺詞元),而一個智慧的「路由機制」會決定哪個專家被激活。這使得模型在面對海量數據時,只會啟動它需要的那一小部分,極大地節省了計算資源。

Phase VI:AGI的願景與四大挑戰——Hassabis 的深層思考

「原生統一」只是基礎,AGI 需要更多突破

雖然 Gemini 三點零 已經是朝向 AGI 邁出的巨大一步,但 DeepMind 的創辦人 Demis Hassabis 本人也一直強調,這種「原生多模態統一訓練」只是必要條件,但還不是充分條件。他估計,真正的 AGI 可能還需要 5 到 10 年的時間,而且需要一兩個額外的重大突破。

▋ 挑戰一:推理深度與邏輯鏈條的不足

第一個瓶頸,也是目前所有大型模型都面臨的問題,就是改進的推理能力。目前的 AI 雖然能做一些多步推理,但它的邏輯鏈條往往不夠深遠、不夠堅固。它很難像人類一樣,對一個複雜問題進行長達幾十步、幾百步的嚴謹邏輯思考和論證。Hassabis 認為,AI 需要更強大的「思維鏈」(Chain-of-Thought)和規劃能力,才能在複雜的、未曾見過的場景中做出正確的判斷。

▋ 挑戰二:長期記憶與跨會話的學習

第二個巨大的挑戰是長期記憶。你現在跟任何 AI 聊天,通常只要會話結束,它就「忘了」你是誰、你上次問了什麼。它沒有持久的上下文保留能力。人類的智能是建立在數十年累積的經驗和記憶上的。

AI 需要一個類似人腦的「海馬體」機制,能夠將重要的知識和經歷編碼並儲存起來,並在未來的會話中隨時調取,做到真正的跨會話學習和個人化成長。

▋ 挑戰三:內部世界模型(Internal World Model)的建立

第三個關鍵,也是最哲學性的挑戰,是建立一個內部世界模型(Internal World Model)。這跟多模態學習高度相關。

一個真正的 AGI,不只要知道世界「長什麼樣子」(多模態理解),它還要知道世界「如何運作」。

這包括對物理法則、社會互動、因果關係的深刻理解。當你推倒一個杯子,它不只知道杯子會倒(視覺識別),它還能預測杯子會碎,或者會滾動(物理模型)。Hassabis 認為,Gemini 這種統一多模態的架構,正在為構建這個複雜的世界模型打下基礎。

▋ 挑戰四:智能體行為(Agentic Behavior)與自主目標

最後一個挑戰是智能體行為(Agentic Behavior)。現在的 AI 都是「被動」的,你給它一個提示(Prompt),它給你一個回應。

它沒有內在的目標、沒有驅動自己的「慾望」。

真正的 AGI 必須具備自主目標設定、多步行動規劃,並且能夠在真實環境中(例如機器人或軟體環境中)主動執行任務的能力。DeepMind 目前在做的 Project Astra(通用助手)和機器人研究,正是朝著這個「具身化」(Embodiment)和「自主智能體」的方向努力。

Phase VII:從「盲人」到「通用智能」的躍遷

▋ 從「模仿語言」到「模仿認知」的範式轉變

所以,回過頭來看最初的觀察,它抓住了 AI 發展史上一個決定性的範式轉變。我們正在從一個只會模仿人類語言(LLM),到一個開始模仿人類認知(原生多模態)的階段躍遷。Gemini 的統一訓練,不只是解決了舊模型的「瞎子摸象」問題,它更為我們開啟了通往 AGI 的大門,讓 AI 第一次具備了像人類嬰兒一樣,直接、統一、且多維度地感知世界的能力。

Gemini 3.0 的歷史地位

我們可以毫不誇張地說,Google Gemini 三點零 的「原生多模態」架構,標誌著通用人工智慧發展的一個新的起點。它證明了所有模態是可以被統一在一個單一、高效的架構下的。這是一個技術上的勝利,更是認知哲學上的勝利。

Gemini 3.0 的出現,標誌著我們終於完成了從「瞎子摸象」到「睜眼看世界」的關鍵性轉變,這是AI史上一個非常重要的里程碑。

▋ AGI 之路:世界模型

雖然我們距離 Demis Hassabis 所說的、那個擁有完整推理能力和世界模型的 AGI,可能還有一段距離,但這個統一架構已經是一個堅實的基石。未來的突破,將在這個堅實的基礎上展開,包括如何賦予 AI 長期的記憶、更深的推理邏輯,以及在複雜世界中自主行動的能力。

但至少,現在的 AI 已經不再是那個只能聽故事的盲人了,它已經「睜開了眼睛」,正在努力學習如何看懂這個複雜的世界。

只有當AI能像人類一樣,用統一的感官來理解物理和社會世界,它才能夠真正地實現通用智能。

#MarkIncome

如果你想收到更多這類貼近現場的思考,

📩 歡迎訂閱我的付費專欄,和我一起拆解 AI 世界裡最需要的「人類力」。

12月限量優惠 > 六折優惠倒數只剩幾天喔